胰腺癌早期诊断困难,病程短,发病速度快,是预后最差的恶性肿瘤之一。胰腺癌Ⅳ期患者确诊后生存期小于1年,5年平均生存率小于1%[1]。图像分割在影像组学、三维可视化技术胰腺癌的早期诊断、鉴别诊断、评估手术获益、疗效评估及预后预测等多个临床诊疗环节均发挥重要作用[2-3]。由于胰颈及胰体部重要血管多,复杂的毗邻结构使图像边界难以准确区分,目前仍多采用手动或半自动的分割方法、耗时费劲且准确性有待提高,而以卷积神经网络为代表的自动分割方法则成为未来进行胰腺分割的首选方法。

随着大规模器官分割标注数据集合的出现和相关技术的发展[4-5],卷积神经网络已经在胰腺周边器官(肝脏、脾脏、左右肾脏等器官)上取得令人满意的效果,但由于胰腺周边复杂的毗邻结构、不同病例胰腺形状的多变性和CT图像中胰腺模糊的边界,造成了现存的基于卷积神经网络的自动分割算法难以精准的分割胰腺。

目前基于卷积神经网络的自动分割算法,大致可以分为两类:2D方法和3D方法。其中2D方法以单张切片为输入,UNet[6]是最为经典的2D方法,Attention UNet[7]是UNet的改进,其使用上层特征监督下层参数的训练,约束参数优化方向。同时对轴状面、冠状面、矢状面3个面进行分割,使用投票的方式融合分割结果[8]。3D方法则以体块作为输入,3D-UNet[9]将UNet[6]中的2D卷积替换为3D卷积,VNet[10]在3D-UNet的基础之上引入了残差结构[11],将级联的思想引入3D网络,使用级联3D网络的形式提升分割效果[12]。使用预测-微调的策略进一步提升了3D网络的分割效果。

2D方法的优点在于可以对单张切片中的特征进行深度挖掘,但其缺点在于仅关注了单张切片的信息却忽视了三维空间信息。3D方法以体数据块作为输入,优点在于可以有效的利用三维空间信息,缺点在于3D方法仅能使用小的切块作为输入,其网络深度也受到了限制,这使得3D方法无法有效的挖掘单张切片的信息,在单张切片上的分割效果差于2D方法。

鉴于目前2D方法和3D方法存在问题,本研究提出了一种可以有效结合2D方法和3D方法优点的2-3D混合网络,综合利用2D方法提取的单张切片的语义信息和3D方法提取的上下文语义信息取得更好的胰腺分割效果。

1 资料与方法 1.1 数据集来源本实验使用的数据集是来自美国国立卫生研究院的NIH[13]胰腺分割公开数据集,其中包含82例腹部CT增强扫描,以及相应体数据的绝对位置、数据密度等信息。扫描分辨率为512×512像素,切片数在181~466之间,层厚为1.5~2.5 mm。

1.2 数据预处理数据预处理步骤包含下述步骤:①窗口范围调整。②数据进行离差标准化,将像素值映射到[0, 1]之间。③数据裁剪和缩放。

具体操作步骤如下:

① 在原始腹部CT图像中,各组织的HU值范围不同。其中常见的胰腺HU值范围为30~55,根据像素值-HU值转换方程,计算出胰腺的窗口范围,再对其进行适度延伸,最终得出的胰腺窗口范围为[-300, 300]。其中像素值-HU值转换方程如下所示,其中Pixel表示像素值,ScaleFactor表示放缩倍率,Bias表示偏差值。

② 依照得出的胰腺窗口范围对其进行截断,再对截断后的数据进行离差标准化,其中离差标准化的公式如下所示:

③ 由于胰腺位置相对固定,我们首先对胰腺的位置进行统计,再根据统计的位置信息对胰腺进行裁剪,将图像从512×512裁剪为256×256,再使用二次线性差值将图像从256×256下采样至128×128。

1.3 使用2-3D混合网络进行胰腺分割预处理之后,我们已经在一定程度上排除了其余器官对胰腺的干扰,并根据统计的胰腺位置信息对图像进行了裁剪,在此基础之上对其使用2-3D混合卷积神经网络进行分割可以得到更好的效果。

本研究使用的2-3D混合网络主要分为2D部分和3D部分。其中2D部分使用的是主干网络为ResNet34[14]的ResUNet,编码器通道数设置为(64, 128, 256, 512, 1 024),每个残差组使用的残差单元数量为(3, 4, 6, 3, 2)。解码器部分每个残差组使用的残差单元数量为(1, 1, 1, 1),步长为2的卷积层和反卷积层被应用于下采样和上采样,具体设置参照ResNet[14]。3D部分使用的是主干网络为ResNet18-3D的VNet[10]网络,解码器通道数设置为(32, 64, 128, 256), 每个残差组使用的残差单元数量为(2, 2, 2, 2)。解码器部分每个残差组使用的残差单元数量为(1, 1, 1), 步长为2的3D卷积层和3D反卷积层被应用于下采样和上采样,具体设置参照VNet[10]。

具体分割流程包含下述步骤:①对预处理之后的CT图像进行重新组织,获取2D网络输入和3D网络原始输入。②将2D网络输入送入2D模型获取2D分割结果和2D多尺度语义特征。其中2D多尺度语义特征指的是将图像CT特征输入卷积神经网络后,经过不同数量的卷积和下采样层得到的不同分辨率的特征信息。③对2D分割结果进行转换,转换成为3D形式并同3D网络原始输入进行结合得到3D网络输入。④将2D多尺度语义特征进行转换,转换为3D形式的特征。⑤将步骤③得到的3D网络输入和步骤④得到的3D特征输入3D模型,获取3D分割结果。⑥对步骤⑤得到的3D分割结果进行3D最大连通域处理,得到最终的分割结果。2-3D混合网络算法的网络架构图如图 1所示。

|

| 图 1 胰腺分割算法的网络构架 |

1.4 模型训练方法

胰腺CT图像数据集来自于公开的胰腺分割数据集:NIH[13]胰腺分割数据集。我们对其进行了五折交叉验证,每折中选取其中的61(60)套作为训练集,5套作为验证集,16(17)套作为测试集。因为2D特征同3D特征相差较大,直接训练容易导致模型无法收敛,从而导致分割结果的精度较低,故而将训练过程分为3个阶段:①单独训练2-3D混合模型中的2D网络。②固定2D网络参数,单独训练3D网络。③对2D网络和3D网络进行联合训练,对参数进行微调。学习率为5E-5的Adam优化器和下述损失函数被应用于以上3个阶段:

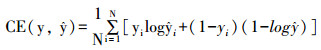

其中交叉熵损失(CE)和DICE损失具体公式如下:

其中

本文利用医学图像分割中常用的Dice系数来评估模型的分割效果,Dice系数公式如下:

其中

利用pytorch深度学习框架对2D卷积神经网络、3D卷积神经网路和2-3D卷积神经网络的胰腺分割算法编程实现。其中2D网络指的是本研究提出的2-3D混合网络中的2D部分,3D网络指的是本研究提出的2-3D混合网络中的3D部分。

本研究在NIH[13]数据集上对2D、3D和2-3D方法进行了测试,结果如表 1所示,2-3D方法在平均值、最小值、最大值上均高于2D方法和3D方法,同时2-3D方法方差小于2D方法,远小于3D方法,这证明2-3D方法更加稳定可靠。除此之外,本研究还与主流的医学图像分割方法进行了比较,结果如表 2所示,其中带“*”的方法表示该方法使用了与本研究同样的数据集进行重新训练。

| 组别 | 2D | 3D | 2-3D |

| 最大值 | 90.25% | 89.75% | 90.65% |

| 最小值 | 63.94% | 56.39% | 67.04% |

| 平均值+方差 | 82.43%±5.56 | 81.82%±7.65 | 83.2%±5.08 |

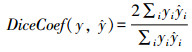

准确的胰腺分割对手术计划的制定、放射治疗具有重要意义。错误的胰腺分割对后续的治疗具有极为恶劣的影响。图 2给出了2D网络、3D网络以及本文提出的2-3D混合网络在单张切片上的分割结果。如图 2第1行代表在当前切片胰腺目标极小时的情况:2D分割方法在当前切片胰腺目标较小时难以进行准确的分割,出现漏检的情况,3D方法虽然成功的分割出了胰腺,但是分割结果同手工标注有较大差异,2-3D方法成功分割出胰腺并取得了较好的分割效果。如图 2第2、3行代表在当前切片胰腺目标较大时的情况:2D、3D和本研究提出的2-3D方法均能较好的分割出胰腺,但2-3D方法分割出的胰腺组织相比于2D方法和3D方法分割出的胰腺,在轮廓形态上与对应的手工标注图吻合度更高,更准确。

|

| 图 2 CT图像的胰腺分割结果 |

同时我们可对胰腺分割结果进行进一步的处理,处理后的数据可以应用于解剖教学和3D打印。图 3展示了2D、3D、2-3D方法得出的胰腺分割结果和手工标注胰腺的三维重建效果展示图。相比于手工标注的胰腺,2-3D方法得出的胰腺分割结果轮廓更为平滑、细腻。相比于2D方法,2-3D方法有效综合了三维空间信息,对胰腺边缘位置进行了补足,避免了在胰腺边缘出现的漏分割情况。相比于3D方法,2-3D方法有效地利用了2D方法提供的语义信息,规避了在胰腺边缘出现的错误分割的情况。在临床应用中,使用2-3D方法得出胰腺分割结果进行3D打印,得出的胰腺模型不会出现突出和截断情况,其形状更加接近病人的真实胰腺。

|

| A: 手工标注胰腺的三维重建效果;B: 2D部分得出的胰腺分割结果三维重建效果; C: 3D部分得出的胰腺分割结果三维重建效果; D: 2-3D混合卷积神经网络得出的胰腺分割结果三维重建效果 图 3 胰腺分割结果的三维重建效果 |

3 讨论

精准的胰腺分割有助于医生进行简单、快速、准确的CT图像分析,可以有效地减轻医学专家的工作量,提高医生工作效率[17]。提升胰腺相关疾病的诊断效率和准确性。在课堂教学中利用胰腺分割结果进行的器官三维重建可以作为辅助教学手段提升教学效率,提高学生对相关知识的理解。在临床实践中,利用胰腺分割结果进行的器官三维重建可以有效辅助医生判断病灶、规划手术方案提升手术成功率。可见,准确的胰腺自动分割是进行胰腺相关疾病的早期诊断、影像组学分析、精准放疗、3D打印、课堂教学等任务的重要基础步骤。

针对2D方法和3D方法存在的问题: 2D方法无法利用三维空间信息,3D方法无法深度挖掘单张切片信息。本研究提出了1种针对胰腺CT图像全自动分割方法,有效的综合了2D方法和3D方法的优点,并规避了2D方法和3D方法的缺点,创新性的将2D网络和3D网络进行有机结合。相比于单独2D方法或3D方法,2-3D混合方法可以有效地提升胰腺分割的准确度,从分割结果的三维效果展示图来看,2-3D方法得出三维效果展示图较之于2D方法更显平滑、细腻且在边缘位置仍能进行准确的分割,不存在漏分割的情况,较之于3D方法,其分割结果更为准确且减少了错分割的情况。

在后续的工作中,可以通过改变2-3D混合网络中2D部分和3D部分的网络结构来达到更好的分割效果,也可以从2-3D信息融合方式上下功夫,得到更有效的信息融合方式。可见,本研究提出的2-3D混合网络仍有巨大的改进空间,同时新颖的2-3D混合卷积神经网络结构对后续进一步提升胰腺分割的效果具有启发意义。

| [1] |

CHAN-SENG-YUE M, KIM J C, WILSON G W, et al. Transcription phenotypes of pancreatic cancer are driven by genomic events during tumor evolution[J]. Nat Genet, 2020, 52(2): 231-240. |

| [2] |

何铭, 薛华丹, 金征宇. 影像组学在胰腺癌的应用及研究进展[J]. 中华放射学杂志, 2020, 54(10): 1029-1032. HE M, XUE H D, JIN Z Y. Radiomics in pancreatic cancer: the state of art[J]. Chin J Radiol, 2020, 54(10): 1029-1032. |

| [3] |

李仓, 吴晓康, 厉学民, 等. 三维可视化技术结合3D腹腔镜在胰腺中段切除术中的临床应用[J]. 中华胰腺病杂志, 2020(6): 434-437. LI C, WU X K, LI X M, et al. Clinical application of 3D visualization technology combined with 3D laparoscopy in the resection of middle segment pancreatectomy[J]. Chin J Pancreatol, 2020(6): 434-437. |

| [4] |

ZHOU Y Y, XIE L X, SHEN W, et al. A fixed-point model for pancreas segmentation in abdominal CT scans[M]//Medical Image Computing and Computer Assisted Intervention-MICCAI 2017. Cham: Springer International Publishing, 2017: 693-701. DOI: 10.1007/978-3-319-66182-7_79

|

| [5] |

ROTHH R, SHEN C, ODA H, et al. Deep learning and its application to medical image segmentation[J]. Med Imaging Technol, 2018, 36. |

| [6] |

RONNEBERGER O, FISCHER P, BROX T. U-Net: Convolutional Networks for Biomedical Image Segmentation[C]. MICCAI, 2015, 9351. 234-241. DOI: 10.1007/978-3-319-24574-4_28.

|

| [7] |

OKTAYO, SCHLEMPER J, FOLGOC L L, et al. Attention U-net: learning where to look for the pancreas[EB/OL]. 2018.

|

| [8] |

ZHOUX R, ITO T, TAKAYAMA R, et al. Three-dimensional CT image segmentation by combining 2D fully convolutional network with 3D majority voting[M]//Deep Learning and Data Labeling for Medical Applications. Cham: Springer International Publishing, 2016: 111-120. DOI: 10.1007/978-3-319-46976-8_12.

|

| [9] |

ÇIÇEK Ö, ABDULKADIRA, LIENKAMP S S, et al. 3D U-net: learning dense volumetric segmentation from sparse annotation[C]//Med Image Comput Comput Assist Interv MICCAI, 2016: 424-432. DOI: 10.1007/978-3-319-46723-8_49.

|

| [10] |

MILLETARIF, NAVAB N, AHMADI S A. V-net: fully convolutional neural networks for volumetric medical image segmentation[C]//2016 Fourth International Conference on 3D Vision (3DV). October 25-28, 2016, Stanford, CA, USA. IEEE, 2016: 565-571. DOI: 10.1109/3DV.2016.79.

|

| [11] |

ROTHH R, ODA H, ZHOU X R, et al. An application of cascaded 3D fully convolutional networks for medical image segmentation[J]. Comput Med Imaging Graph, 2018, 66: 90-99. |

| [12] |

NWE T L, MIN O Z, GOPALAKRISHNAN S, et al. Improving 3D brain tumor segmentation with predict-refine mechanism using saliency and feature maps[C]//2020 IEEE International Conference on Image Processing (ICIP). October 25-28, 2020, Abu Dhabi, United Arab Emirates. IEEE, 2020: 2671-2675. DOI: 10.1109/ICIP40778.2020.9190806.

|

| [13] |

Roth H R, Lu L, Farag A, et al. DeepOrgan: Multi-level Deep Convolutional Networks for Automated Pancreas Segmentation[C]//International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham: Springer, 2015: 556-564. DOI: 10.1007/978-3-319-24553-9_68.

|

| [14] |

HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). June 27-30, 2016, Las Vegas, USA. IEEE, 2016: 770-778. DOI: 10.1109/CVPR.2016.90.

|

| [15] |

SHELHAMERE, LONG J, DARRELL T. Fully convolutional networks for semantic segmentation[J]. IEEE Trans Pattern Anal Mach Intell, 2017, 39(4): 640-651. |

| [16] |

ROTH H R, ODA H, ZHOU X R, et al. An application of cascaded 3D fully convolutional networks for medical image segmentation[J]. Comput Med Imaging Graph, 2018, 66: 90-99. |

| [17] |

郑彩侠, 张同舟, 孙长江, 等. 图像分割方法在医学领域中的应用[J]. 中国医疗设备, 2018, 33(6): 1-5, 11. ZHENG C X, ZHANG T Z, SUN C J, et al. Application of image segmentation methods in the medical field[J]. China Med Devices, 2018, 33(6): 1-5, 11. |